Shownotes Transcript

科技不应该是少数人的专利用通俗一种的语言将复杂的科技概念和商业话题讲得明明白白各位听友早上下午晚上好取决于你现在是什么时间在听欢迎来到本期的解密科技我录这期节目的时间是北京时间 2025 年的 2 月 27 号

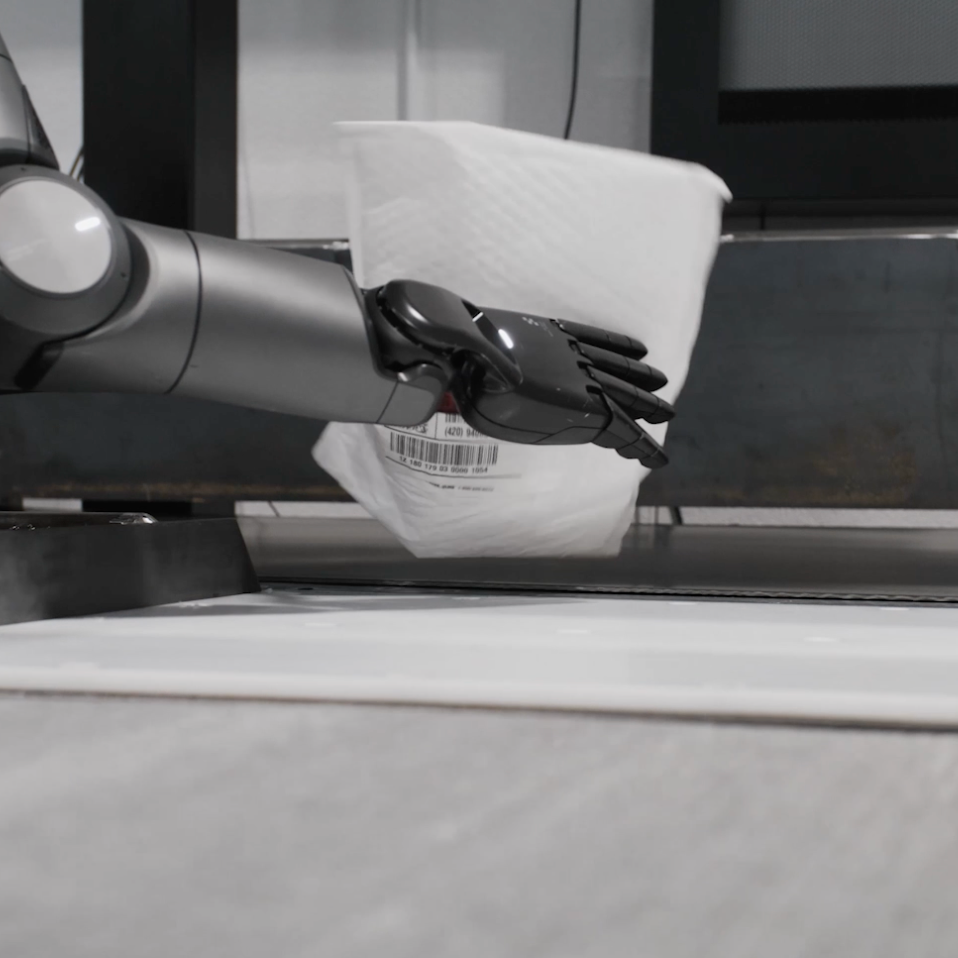

昨天晚上,也就是美国时间 2 月 26 号,美国的人行机器人界的当红炸子机 Figure AI 展示了他们自研的端到端的人行机器人大模型 Helix 驱动下的这个机器人在高速运转的包裹物流产线上工作的一个视频这是 Figure 这家公司的机器人的第二个实际上去产线工作的商业的应用

第一个商业客户商业应用是去年的这个时间 Figler 机器人去到了第一个商业客户宝马公司的工厂做工 Figler 创始人今天说真正令人兴奋的是我们与宝马的第一个应用案例花了 12 个月的时间而第二个应用案例仅用了 30 天通过 Helix 人型机器人大模型他们自家自研的这个 AI 现在呢我们已经能够通过一个端到端的神经元网络让机器人完全自主的运行

这期播客我就和大家一起分享一下 Figure AI 的这个 Helix 人形机器人大模型是如何加速真实的物流世界的在此之前呢咱们先简单的来一个前行提要 Figure AI 这家公司国内媒体报道的很少这家公司成立于 2022 年创始人是一个成功的连续创业者之前他成功退出的公司包括一家招聘服务公司一家做电动垂直起降飞机的 Evato 的公司

Evato 就是去年咱们这里很火的低空经济的一个产品代表今年好像低空经济也不太提了对低空经济和 Evato 感兴趣的听友可以去我的第 27 期节目里面有详细介绍目前除了 Figure AI 这位创始人还在同时经营着另外两家初创公司这个风格跟马斯克很像了

Figure AI 这家公司得到了世界首富 Jeff BezosOpenAI、微软、英伟大等等头部的公司和一些创投机构的投资我的第 12 期和 21 期节目对这家公司和它的创始人有详细的介绍在 2025 年的 2 月 20 号 Figure AI 发布了自己的端到端的人形机器人大模型 Helix 在此之前 Figure AI 的人形机器人一直用的是 OpenAI 的大模型

在今年的 2 月初,Figure AI 的创始人和 CEO 宣布,停止和 OpenAI 的合作,转向用字眼的大模型。对这一个巨大的转变,这个创始人他的解释也非常的透明和坦诚,他说我们不能再将 AI 大模型外包出去了,就如同我们不能将硬件外包一样。

所以在 2 月初宣布停止使用 OpenAI 大模型之后转向自研大模型的两周 Figure AI 就发布了自家的人形机器人大模型 Helix 同时也展示了一段长达三分多钟的视频是一镜到底用他们的话说并没有任何的剪辑或者是说人工的远程的操控

那个视频当中,Helix 端到端的大模型驱动了两个人形机器人,它完美地展示了没有经过提前的排练或者沟通等等,在收到一系列的这两个机器人从未见过的家庭用品之后,两个机器人配合着交互协作,把这些物品分门别类归位到了冰箱、橱柜、垃圾箱等等不同的位置里面去。

那段视频在展示了 Figure AI 的机器人完整的上半身控制的同时,更重要的是展示了 Helix 大模型的几个重要的核心能力。完整的上半身控制指的是让机器人实时灵活地控制上半身的所有部分,包括肩膀、胳膊、手腕、每个手指,甚至是头部和躯干,就像人一样自然地动起来。

黑力克斯大模型的几个重要的核心的能力是一是机器人之间的主动的协同工作机器人主动的自我学习控制能力就是机器人去自动的学习和感知周围的环境据此来决定应该产生怎样的行为而不是依赖于传统的手工编程去实现特定的控制规则

以及机器人强大的泛滑能力也就是说泛滑能力是指在学会一件事之后能把这件事用在没有见过的新的情况上而不是只会死经被按照提前编程好的规则去机械的执行我的第 101 期节目对这个新的 Helix 人形机器人的大模型有一个完整的介绍

在今天发布的物流生产线上的视频和 paper 里面 Figure 说将人型机器人引入劳动力市场是 Figure 使命的核心今天推出了 Figure 机器人在现实世界当中的新的应用物流包裹的操作和分解这个任务要求达到人类水平的速度精确度和适应性完成了这个任务就把 Helix 大模型从视觉捕捉到像素再到动作

学习和操控这一个端到端的操作能力推到了一个新的高度 Figure 一周之前发布的 Helix 人形机器人的大模型它统一了感知语言理解和学习控制智能的机器人需要强大的泛化能力但具有强大泛化能力的大模型通常想象速度又比较慢但智能机器人同时还需要有高速的计算和控制能力去让机器人能够做出快速的反应和动作

为了解决人型机器人领域的传统矛盾 Figure 的 Helix 大模型分成了两个子系统 S2 来实现强大的泛滑能力 S1 子系统来快速地完成控制能力和动作能力现在 Figure 又对 Helix 系统的 S1 又做了一系列的改进来适应这种新的具有挑战性的实际的商业应用这些改进包括第一是叫做隐世的立体视觉

演示的立体视觉是指系统通过两个摄像头立体视觉来获取不同角度的图像从而生成深度的立体信息来帮助机器人理解物体的距离和空间位置这种技术能够使机器人在复杂的环境中更加准确地进行操作和运动尤其是在处理不同距离的物体的时候提高了控制的精度

Helix 系统 1 现在拥有了丰富的 3D 理解能够实现更加精确的深度的感知运动

在人型机器人行业里面用两个摄像头获取深度的信息实现三维空间的感知是一种常见的做法 Helix 系统一所提到的他们的隐世立体视觉可能与传统的立体视觉有所不同在算法和数据处理上有一些独特的做法在这方面 Figure 并没有去过多的介绍更多的细节第二个改进是叫做多尺度的视觉表示

低级的策略用来捕捉精细的细节同时保留场景层次的理解以实现更精确的操作这段话说人话呢它的意思是说系统能够在不同的层次上去理解图像这种方法呢使得系统既能够捕捉到非常细微的细节又能够理解场景中的宏观结构从而使得机器人在操作的时候更加的精确和灵活

比如在抓取一个物体的时候机器人不仅能够感知到物体的具体的边缘和形状的细节还能够准确地理解物体所在的背景和它与其他物体的关系这种场景的层次这种方法能够帮助机器人更加高效地去执行任务

总结前两点的优化就是隐世的立体视觉提供了空间的深度信息而多尺度的视觉表示则处理了图像的细节和结构的层次这两者的结合可以使机器人在实际应用当中更加的智能和高效第三个优化是指的学习型的叫做学习型视觉本体感知这个有一点复杂听起来但是它说的什么意思呢是说每个 figure 机器人

现在能够自我校准使得跨机器人的这种交互变得更加的无缝了视觉本体感知是一个术语它指的是机器人通过视觉感知来理解自身的状态比如来了解我的手臂手指等部件在空间当中的位置和姿态这就是自我感知

学习型表示的这种感知是通过机器学习的模型来训练的而不是通过传统的机械传感器或者是预设的一些规则来实现的这就意味着机器人通过不断的学习环境当中的数据能够自我调整并且提升感知的精度

自我校准指的是机器人不需要外部手动调整而是可以根据自己的视觉输入来进行自行修正和调整自己的定位或者是做传感器的校准这些全部都是通过机器学习的模型来完成的而不是依赖于人工的输入

具体来说呢就是机器人能够通过摄像头或者是其他的传感器的视觉信息来自动估算自己在三维空间中的姿态和位置这个里的跨机器人的转移呢经过自我校准的机器指的是说经过校准的机器人能够将其学到的操作策略应用到其他机器人身上而不需要单独的对每个机器人进行复杂的重新校准或者是训练

由于机器人能够自动调整自己并了解自己的状态,他们能够在不同机器人之间快速地共享和适应相同的控制策略,确保多个机器人在执行任务的时候保持一致的操作效果。

如果总结一下,这一点,学习型视觉本体感知,这个优化强调了 Figure 机器人在自我感知和自我调整方面的进步,使得他们能够在没有外界人工干预的情况之下,

自动的去修正自身的位置和姿态并能够在不同的机器人之间共享经验和策略保持操作的一致性和高效性这使得这个机器人群体的管理和扩展变得的变得可能了并且是更加的灵活高效尤其是在这个大规模部署很多机器人的时候第四个优化呢是这个叫做 Figure 引入了一个运动模式它是通过一些个

测试时间和加速技术它实现了比训练时的专家示范更快的一个执行速度同时还保持了高成功率和这种灵活性

测试时间加速技术指的是在实际执行任务的时候通过某种算法对机器人的动作进行加速具体来说就是说对机器人的动作进行重新采样或者是调整这样的话在不改变机器人训练过程的前提之下在训练之后在实际上执行任务的时候加速了执行的速度

那 Figure 要应对的真实的应用案例场景到底是什么样子呢它是物流行业的常见的包裹处理和分解这是物流行业里面的一个基础操作它通常涉及到将包裹从一条传输带转移到另外一个传输带同时还要确保运输标签正确的朝向以便机器去扫描

这个任务它有几个关键的挑战首先这个包裹可能是不同的尺寸不同的形状重量和不同的刚性有这个硬的盒子也有这种软的可以变形的袋子

这使得模拟训练的过程中复制这些过程非常困难机器人系统必须能够确定最佳的抓取时机和方法将运动中的物体抓住并且重新定位每一个包裹把他的扫描标签暴露到正确的方向上此外还需要追踪连续移动传输带上大量包裹的动态流动

保持一种高的囤土量因为这种环境基本上是完全无法预测的所以系统必须具备自我修正的能力 Figure 说解决这些挑战不仅是 Figure 业务的关键应用而且还能够为整个 Helix 的系统 1 带来了一个通用性的改进这种通用性的改进在其他的场景当中也会受益

那 Figure 是如何实现前面提到的物流行业的特定优化呢?这一个首先在视觉表示方面,视觉表示指的是计算机视觉系统或者机器人如何将视觉的信息,图像,视频等等,转化为机器人能够理解和处理的格式。

在视觉表示方面之前的系统 1 里面 Figure 是依赖于单目视觉输入也就是说只使用了一个摄像头单眼摄像头来获取视觉的信息

而现在新的系统 1 则利用了立体视觉骨干网络也就是说使用了两个摄像头来获取两个不同角度的图像类似于人眼的人类的这种双眼的视差从而更加准确地理解深度的信息 3D 的空间并结合多尺度的这种特征来提取网络这样的话系统可以从不同的尺度的图像特征当中提取信息

既能够理解细节的信息也能够掌握整个环境的上下文这样捕捉出来的丰富的空间层次结构它不同于以前独立从每一个摄像机当中获取图像的这个

图像内容的数字特征现在来自两个相机的图像内容的数字特征在这种多尺度的立体网络当中进行合并再进行数字图像的内容的特征化

这样的话呢可以保持输入到整个这个模型里面系统一里面的这个他们叫做交叉注意力 transformer 这个计算架构里的这个视觉数字特征的数量不变仍然是一个输入这样的话呢避免了额外增加额外的计算的开销

这种多尺度的特征使得系统能够解读的细节信息并且还能够了解到更加广泛的环境上的商下文的线索从而提高了整个视觉控制的可靠性在跨机器人迁移方面跨机器人迁移主要指的是将一个已经训练好的控制策略应用到多台不同的机器人上

硬件行业和软件行业特别不一样的一点是软件同样的代码写好了之后比如开发测试好了的一个 APP 在不同的 iPhone 上它的表现是可以预知的是一定是一样的但在硬件行业比如机器人虽然说每一台机器人的硬件都是同样的零部件来自于同样的厂家

但同样的零部件它的实际的表现可能是有所不同的这是非常跟软件不一样的地方也是咱们大家通常难以想象的一点这个不同就可能会带来一些问题比如这种传感器校准的差异不同机器人的传感器比如它的摄像头和深度传感器等等它的精度和校准的方式也可能不同这会导致机器人的视觉输入就不一样了

再比如这种关节的响应特征每个机器人的关节虽然说都是同样的零部件来自于同一个厂家但是它的关节或者是动作的执行器它的实际反应也可能不一样这样的话就可能导致同样的控制命令在不同的机器人上执行的效果也有所差异

这些差异就会影响机器人的控制策略和整体的表现特别是在涉及到复杂的动作空间的时候比如在控制机器人上半身的动作的时候传统的这种手动的校准方法就很难在大量的机器人上去有效的扩展了

所以为了解决这种跨机器人迁移的问题 Figure 在多台机器人上部署训练好的单一策略的时候就需要去解决个别机器人的硬件差异引起的观察和动作空间的偏移

那这些差异呢如果没有得到适当的补偿就可能会影响到策略的性能特别是在这种高维度刚才前面说了高维度的这种上半身的动作的空间当中那因此呢 Figure 就训练了一个叫做视觉本体感知模型完全通过每台机器人的机载的视觉输入来估算末端执行器的这种 6D 的 6 维空间的这种姿态

这种在线的自我校准使得机器人的策略歉意变得更加的顺畅并将整个的停机的时间最小化在训练数据方面 Figure 提到了说他们特别注意筛选人类的演示排除了那些个比较慢错过了或者是失败的演示但同时呢也刻意的保留了那些个自然的包含了去纠正行为的这样的演示

当纠正的失败是由于环境的随机性产生的时候而非操作员的错误产生的时候这样的数据演示是具有重要的意义的这样的话就进一步的优化统一了这种操作策略也带来了整体性能的显著的一个改进再多介绍一下运动模式它们是怎么实现的

就是说在训练的时候保持原来的这种训练的方式不变但是在实际上推理的过程当中操作加速 Figure 希望机器人在推理实际的工作当中能够接近并且最终超越人类的速度这个加速的动作是怎么做到的呢我们用教机器人跳舞这样的一个例子来解释一下在训练的时候

机器人会老老实实的按照比方说一秒的这种节奏去跳一秒钟完成了所要完成的动作但是现在如果想让机器人在实际跳的时候跳得更快一点超过训练时候这个速度 Figure 想了一个办法

把这个一秒的动作去剪辑成一个 0.8 秒的一个版本怎么剪呢不是直接删掉了而是把整个动作挤一下就相当于是压缩了把这个时间从一秒压缩到了 0.8 秒这样的话就缩短了 20%这种挤完了之后呢在实际执行的过程当中 Figure 现在的机器人的 SE 系统的执行的

频率是一秒钟 200 次所以在实际执行过程当中机器人还是每秒喊 200 次的口令去执行但因为总的时间变短了它就比原来的跳得快了 20%就像你把一首歌的节奏给加快了但是歌词和旋律都没有变只是唱得更快了

而且最关键的一点是这个剪辑或者压缩的过程当中这个过程是不需要重新去教机器人跳舞原来的学习过程不变只是在最后实际跳的时候节奏加快了这是个挺聪明的一个做法通过上面这些个一系列的优化 Figure 也发现了训练的数据的质量重要性要高于训练的数量对于单一的这种应用场景

数据的质量和一致性比数据的数量更加重要 Figure 发现说即使训练的数据量减少了三分之一如果是使用了经过精心筛选的高质量的示范训练的模型仍然能够实现比其他的模型高出 40%的吞吐量

在运动模式方面虽然说前面讲到了这种压缩的模式这种加速的策略有效的提高了速度但是 Figure 发现最高目前可以提升 50%当这个提升的速度超过 50%的时候实际的吞吐量开始大幅的下降了因为动作变得不够精确了系统需要频繁的进行重置 Figure 通过今天的这个

接近于两分钟的视频它展示了如何通过高质量的数据集以及结合架构上的一些改进来实现了真实物流分类场景中超越示范者的灵活的机器人的操作这一切都只是使用了相对较少的示范数据凸显了将端到端的视觉运动策略拓展到需要速度和精度的复杂工业应用当中的一个巨大的潜力

在结束今天的节目之前我想邀请大家一起思考一下你们觉得人型机器人是否能够真正成为我们日常生活当中的一部分呢 Figure 通过最近一周之内两次 Helix 机器大模型所展示出来的惊人的进步

已经让机器人从实验室的概念走到了实际的应用当中了尤其是已经在物流行业真正的开始应用了这不仅仅是技术的一个进步更是整个社会工作模式的一个潜在的一个变革那在未来的工作场所你觉得机器人能够取代哪些重复性高的工作呢能够为我们的这个职业生活带来怎样的一个变化呢欢迎在这个评论区留言这只是一个开始随着技术的不断进步

机器人将如何在其他的行业当中找到自己的身影呢也许下一步我们会看到更多的行业用机器人来提高生产力甚至是创造出全新的工作岗位来如果你对未来科技和人工智能感兴趣欢迎订阅揭秘科技并留言分享你的看法你的每次互动都会成为下一期节目的灵感泉源感谢大家的收听欢迎在下期节目当中再见