We're sunsetting PodQuest on 2025-07-28. Thank you for your support!

Export Podcast Subscriptions

Shownotes Transcript

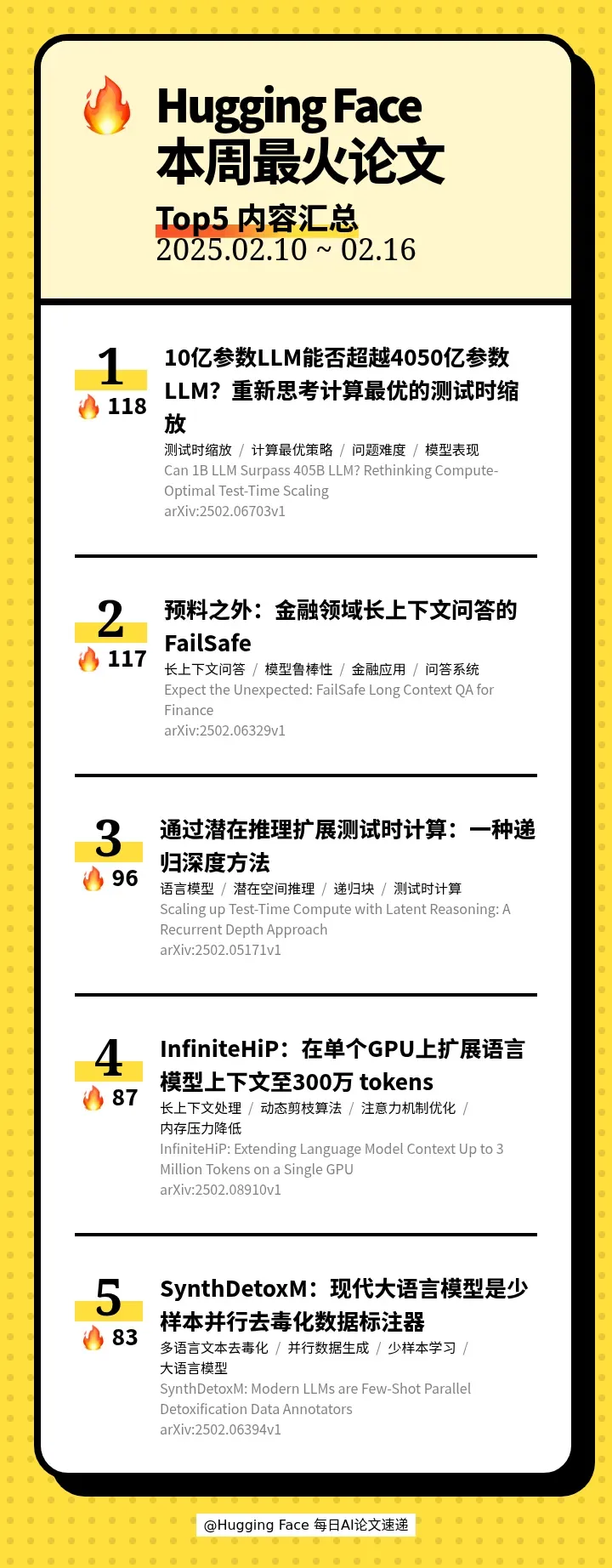

本期的 5 篇论文如下:

[00:45] TOP1(🔥118) | 🤔 Can 1B LLM Surpass 405B LLM? Rethinking Compute-Optimal Test-Time Scaling(10亿参数LLM能否超越4050亿参数LLM?重新思考计算最优的测试时缩放)

[03:20] TOP2(🔥117) | 💼 Expect the Unexpected: FailSafe Long Context QA for Finance(预料之外:金融领域长上下文问答的FailSafe)

[06:07] TOP3(🔥96) | 🧠 Scaling up Test-Time Compute with Latent Reasoning: A Recurrent Depth Approach(通过潜在推理扩展测试时计算:一种递归深度方法)

[08:46] TOP4(🔥87) | 🚀 InfiniteHiP: Extending Language Model Context Up to 3 Million Tokens on a Single GPU(InfiniteHiP:在单个GPU上扩展语言模型上下文至300万 tokens)

[11:12] TOP5(🔥83) | 🤖 SynthDetoxM: Modern LLMs are Few-Shot Parallel Detoxification Data Annotators(SynthDetoxM:现代大语言模型是少样本并行去毒化数据标注器)

【关注我们】

【关注我们】

您还可以在以下平台找到我们,获得播客内容以外更多信息

小红书: AI速递