Why Compound AI + Open Source will beat Closed AI

Latent Space: The AI Engineer Podcast — Practitioners talking LLMs, CodeGen, Agents, Multimodality, AI UX, GPU Infra and all things Software 3.0

Deep Dive

- Fireworks AI initially planned to be a PyTorch cloud platform.

- The release of ChatGPT in late 2022 influenced Fireworks AI to specialize in generative AI.

- Fireworks AI focuses on inference due to its importance in generative AI applications.

Shownotes Transcript

我不想围绕这个堆栈建立一个社区,也不想建立一种新的标准,我认为这是目前行业中有趣的动态。当更多的标准出现在OpenAI周围时,因为他们正在创建顶层,或者在Lama周围,因为这是最常用的模型。所以我认为在这个时候工作会很有趣。

我对Lama C有点怀疑。我认为你对它更积极,基本上它就像是Meta版本的Hugging Face所提供的,或者TensorRT,或者其他开源机会。但对我来说,显然并不清楚,仅仅因为Lama是开源的,其他所有的Lama堆栈就会被采用,也不清楚我为什么应该采用它。

现在还很早。这就是为什么我与他们密切合作并给他们反馈,反馈对Meta团队非常重要。这样他们可以利用这些反馈继续改进模型,并改善更高层次的堆栈。我认为堆栈的成功将取决于社区的参与,而我知道Meta希望与更广泛的社区合作,但现在还很早。

在B轮融资之后,我记得在你们的B轮融资公告时我与您保持密切联系。你们开始重金押注这个“复合AI”的术语,这个术语在我们的播客中并没有被广泛讨论。但我认为它确实得到了来自Databricks和伯克利团队的广泛采用。你对复合AI的看法是什么?

为什么它能引起人们的共鸣?所以请给我一点背景,考虑一下这个领域。

因为之前没有,所以现在在你的语言上。

所以这是一种非常自然的演变,从我们首次推出公共平台时开始。我们是单一产品。我们是分布式推理引擎,我们在定制化方面做了很多创新,构建了分布式、解耦的执行、推理执行,构建了各种缓存。

所以这是其中之一,所以这条产品线是第一个最具特定性的产品,因为我们有一个特殊的PyTorch版本,结合客户的需求,我们投票,然后与更多客户合作。我们意识到,推理引擎的设计是“一刀切”的,我们希望有这个推理端点,然后每个人都可以进来,无论他们有什么样的工作负载,我们都能为他们工作,这很好。

但现实是,我们意识到所有客户都有不同类型的用例。用例以各种不同的形式出现,最终结果是他们的推理工作负载中的数据分布与模型的训练数据分布不一致,这实际上是一个给定的事实,如果你想想,因为研究人员必须估计哪些是重要的,哪些是不重要的,以准备训练数据。

因此,由于这种不匹配,我们在质量、延迟和成本方面留下了很多改进的空间。因此,我们说,好吧,我们想要大力投资于一个定制引擎。我们宣布了一个叫做Fire Optimizer的工具。

Fire Optimizer基本上帮助用户在质量、延迟和成本之间的三维优化空间中导航。它是一个三维曲线,即使对于同一家公司,对于不同的用例,他们希望落在不同的点上。

因此,我们为客户自动化这个过程,非常简单。你有你的推理工作负载。你将其注入到优化器中,并附上我们的目标函数。

然后我们输出推理部署配置和模型设置。所以这是你的定制设置。这是一个完全不同的产品。

这个产品的思维是“一刀切”,而现在在此基础上,我们提供了大量的最先进的模型。

数以百计的模型,从文本到大型英语模型。这是我们开始的地方。然后随着我们与许多客户的交谈,我们意识到音频和文本非常接近。

许多客户开始构建助手,使用文本,并立即想要添加音频输入和输出,因此我们支持转录、翻译、语音合成、文本与音频对齐等各种功能,这是一个重大公告。你应该在这个时候听到。

此外,视觉和文本领域也非常接近,因为很多信息并不以纯文本形式存在,很多信息以多媒体格式存在,包括图像、PDF、屏幕截图和许多其他不同的格式。因此,通常要解决一个问题,我们需要首先使用视觉模型提取信息,然后使用语言模型处理结果,因此视觉模型也很重要。

我们还支持各种不同类型的视觉模型,专门处理不同类型的源和提取。我们还将有另一个公告,支持人们上传各种多媒体内容,然后提取非常准确的信息并将其输入到语言模型中。当然,我们还支持嵌入,因为嵌入对于语义搜索、RAG等非常重要。此外,我们还支持文本到图像、图像生成模型、文本到图像、图像到图像,并且我们还在我们的产品组合中添加文本到视频。

作为一个组合,它是一个非常全面的模型目录,建立在Fire Optimizer和分布式推理引擎之上。但当我们与更多客户交谈时,

他们解决业务用例时,意识到单一模型不足以解决他们的问题。这是非常明显的,因为一个模型的幻觉,许多客户在开始这个旅程时,他们认为这是神奇的,模型会神奇地解决我所有的问题。但他们意识到,这个模型的幻觉。

这是因为它不是确定性的,而是概率性的,因此它被设计为始终给出答案,但基于概率,因此它的幻觉实际上有时是创造性写作的一个特征。例如,有时这是一个缺陷,因为你不想提供错误信息。不同的模型也有不同的专业知识。要解决一个问题,你希望询问不同的专业模型,将任务分解为多个小任务、狭窄任务,然后让专家模型很好地解决该任务。当然,模型并不拥有所有信息,因为训练数据是有限的,而不是无限的,因此模型往往没有实时信息。它不知道企业内部的任何专有信息。

显然,为了真正构建一个复合应用程序,我们需要一个复合AI系统。复合AI系统基本上将拥有多个跨模态的模型,以及API,无论是公共API、内部专有API、存储系统、数据库系统、知识系统,协同工作以提供最佳答案。

你会提供数据库吗?

我们实际上与几家大型数据库提供商密切合作。他们在不同方面都很出色,但这是公开信息,比如MongoDB是我们的投资者,我们已经与他们密切合作了一段时间。

当你说分布式推理引擎时,你到底是什么意思?因为当我听到你的解释时,感觉就像你在通过Fireworks平台集中很多决策,比如质量等。你所说的分布式是指在多个GPU和许多不同的集群中共享推理。

所以,首先,我们在多个GPU上运行。但我们在多个GPU之间分配的方式是独特的。我们不会将整个模型单一地分配到多个GPU上。

我们将它们切成几块,并根据瓶颈的不同进行完全不同的扩展。我们还在不同的区域进行分布。

我们一直在北美、EMEA和亚洲运行。我们对应用程序有区域亲和力,因为延迟极其重要。我们还在进行全球负载均衡,因为很多应用程序会迅速扩展到全球用户。

在那个规模下,不同的内容会在不同的时间唤醒,你希望能够进行负载均衡。因此,所有这些都是,我们还管理来自不同硬件供应商的各种硬件偏差。不同的硬件设计最适合不同类型的工作负载,无论是长上下文、短上下文还是长生成。

因此,所有这些不同类型的工作负载最适合不同类型的硬件,我们甚至可以在不同硬件之间分配工作负载。所以,分布实际上是全栈的。

某个时候,我们将在YouTube上展示Ray正在处理的图像,展示你提供的所有不同模态。对我来说,基本上你提供了开源版本的所有OpenAI通常提供的东西。我认为如果你做文本到视频,你将成为OpenAI所提供的超集,因为他们没有Sora。顺便问一下,是Mochi吗?

是的,Mochi,还有其他几个。我会说,令人感兴趣的是,我认为我们正在押注开源社区将会繁荣。这正是我们所看到的。还有一些令人惊叹的视频生成公司。

是的,还有一些令人惊叹的音频公司,像cross-border,创新是超乎寻常的,我们正在在此基础上构建。我认为这就是我们与封闭源公司相比的优势。

我想重申Fireworks的价值主张,供那些将你与原始GPU提供商(如RunPod或Lambda)进行比较的人使用。你创造了开发者体验层,并且还使其易于扩展或无服务器,或者作为一个端点。然后,我认为对于某些模型,你有自定义内核,但并不是所有模型。

几乎所有大型语言模型都是如此。

是的,几乎所有模型都是如此。

是的,几乎所有模型都是如此。

这被称为Fire Attention。我不记得速度数字,但显然比VLM要好得多,尤其是在并发基础上。

是的,Fire Attention主要针对语言模型,但对于其他模态,我们也将有自定义内核。

我认为人们面临的典型挑战是理解这是否有价值,然后还有其他人也在提供开源模型。你的模式是你为所有这些客户提供良好体验的能力。但如果你的存在完全依赖于人们发布良好的开源模型,其他人也可以做到同样的事情。

是的。所以我会说我们建立在开源模型的基础上,所以这就是我们所建立的基础。

但我们从应用程序开发人员和产品工程师的角度来看待我们的价值主张。他们希望创造新的用户体验。因此,现在行业中发生的事情是,人们正在思考完全新的产品设计方式。我与许多创始人的交谈令人震惊。

他们帮助我理解现有的PowerPoint使用方式、现有的编码方式、现有的客户服务管理方式,实际上是在我们头脑中放置了一个框架。例如,PowerPoint生成是我们总是需要考虑如何将我的故事融入到这种幻灯片格式中,一张接一张。我将不得不在设计和讲述故事之间进行权衡。

但最重要的是,我们的讲述线是什么,对吧?为什么我们不创造一个不受任何格式限制的空间?这些新产品的用户体验设计结合了通过GenAI的自动内容生成,这是许多创始人正在做的新事物。他们面临的挑战是什么?让我们从这里开始。

一个是,因为许多产品建立在GenAI之上,它们是面向消费者的,且需要互动体验。这是我们都习惯的一种产品体验,我们的愿望是获得更快的互动。否则,没有人愿意花时间,因此这会导致低延迟。

另一个问题是,消费者面向开发者的性质是你的受众非常庞大。你希望迅速扩大产品市场适应性。但如果你在小规模上亏损,你将很快破产。

所以这实际上是一个巨大的对比,我实际上有产品市场适应性,但当我扩展时,我却超出了我的业务,这真是非常有趣。因此,低延迟和低成本对于这些新应用和产品的生存至关重要,真正成为一家新兴公司。这就是我们分布式推理引擎和Fire Optimizer的设计点。你可以把它看作是一个反馈循环。

你越是将推理工作负载输入到我们的推理引擎中,我们就越能帮助你提高质量、降低延迟、进一步降低成本。它基本上会变得更好。我们自动化这一过程,因为我们不希望你作为应用开发者或产品工程师去思考如何解决所有这些低级细节,这是不可能的,因为你根本没有接受过这样的训练。你应该专注于产品创新。然后在复合AI中,我们实际上感受到很多痛点,作为应用开发者和工程师,每周至少有一个新模型发布。

是的,最近腾讯发布了一个巨大的模型。

我看到过。我看到过。

我应该继续追逐这个,还是应该忘记它?对吧?那么我应该选择哪个模型来解决什么样的问题?我甚至不知道如何将我的问题分解成更小的问题,并将模型适配到其中。

然后有两种方式来思考这个设计。我想我在过去谈到过。一种是命令式的,你告诉我如何去做。你给开发者工具,指示他们如何去做。

或者你构建一个声明式系统,让开发者告诉他们想要做什么,而不是如何去做。这是完全不同的两种设计。

我想要画的类比是,在数据世界中,数据库管理系统是一个声明式系统,因为人们使用数据库,使用SQL。SQL是一种你说你想从数据库中提取什么的方式。你想要什么样的结果,但你不需要担心哪个节点会运行、你要在多少个节点上运行、如何重新定义你的磁盘、使用哪个索引、使用哪个项目。你不需要担心任何这些。数据库管理系统会生成一个新的最佳计划并执行。

所以数据库是声明式的。这使得它非常简单。你只需学习SQL,了解SQL的语义含义,就可以使用它。命令式的方面有很多ETL管道。人们设计这个DAG系统,带有触发器、操作,你精确地指示要做什么。如果失败,那么如何恢复。因此,这是一个命令式系统。我们在生态系统中看到了一系列系统走不同的道路。我认为两者都有价值。我不认为一个会取代另一个。但我们更倾向于声明式系统的哲学。因为从应用开发者和产品工程师的角度来看,这将是他们最容易集成的。

或者您可以构建一个声明式系统,让开发人员告诉他们想要做什么,而不是怎么做?这些是完全不同的两种设计,对吧?我想打的比方是,在数据领域,数据库管理系统就是一个声明式系统。

因为人们使用数据库,使用 SQL,这是一种方式。你说,你想从数据库中提取什么?你想要什么结果?但是你不会弄清楚哪个节点是。你可以有多少个节点在上面运行,你如何重新定义你的磁盘,你使用哪个索引,哪个项目。你根本不用担心这些。

数据库管理系统会弄清楚,生成一个新的最佳计划,并在其上执行,对吧?所以访问。这让你非常容易。你只需要学习 SQL,也就是学习 SQL 的语义含义,你就可以使用它。在派对方面。

有很多 ETL 管道,人们用触发器、动作设计这个 DAG 系统,你确切地规定要做什么,如果失败了,如何恢复。这是一个重要的系统。我们已经看到生态系统中的一系列系统走不同的路。

我认为两者都有价值。它们很有价值。我认为不会有一个取代另一个,但我们更倾向于声明式系统的理念,因为从应用程序开发人员的角度来看。

工程师,这对他们来说最容易集成。

使用。因此,专注于易用性,然后让系统承担艰巨的挑战和复杂性。因此,我们遵循,我们将这种思维扩展到当前的系统设计中。

因此,另一个公告是,我们还将宣布我们的下一个声明式系统将作为一个具有极高质量的模型出现。这个模型的灵感来自 OpenAI 的 Open 的公告。在我们宣布这个消息的时候,你应该会看到。

内部训练的,是的。这是第一个模型吗?你训练了吗?

这并不是第一个,我们实际上已经训练了一个名为 Fire Function 的模型,这是一个函数调用模型,这是我们进入复合系统的第一步,因为函数调用模型可以将请求分派到多个 API。我们有三个大型 API 集。该模型学习。

您还可以通过配置添加其他 API,让模型相应地分派。因此,我们已经发布了一个非常高质量的函数调用模型。我们实际上有三个版本,最新版本质量很高。

但是现在我们更进一步。你甚至不需要使用函数调用模型。你使用我们即将发布的新模型,它将解决很多问题,接近非常高的 OpenAI 质量。所以我对此非常兴奋。

任何基准测试我们都有基准测试。

我们打算在下周发布它,我们只是将我们的模型提交给了 LMS。人们猜测,这是下一个 Gi 模型还是 Maus 模型?猜测这非常有趣。正在关注 Reddit 的讨论。

现在,当发布 o1 时,很多人都在问它是一个单一模型还是一系列模型。Noam 和基本上草莓团队的每个人都非常坚持认为,他们对强化学习的思考链,不能通过一堆开源模型调用来复制。你认为这是错的吗?你是否做了与他们一样多的 RL 工作,或者这是一个不同的方向?

我认为他们采用了一种非常具体的方法,团队的能力非常高,对吧?所以我认为他们在做他们正在做的事情方面是领域专家,但我认为实现目标的方法不止一种。我们在方向上是一致的,因为质量缩放定律正在从训练转向推理。

我们绝对诚实地说,我完全同意他们,但我们正在采用一种完全不同的方法来解决这个问题。所有这一切都是因为,当然,我们没有从头开始训练模型。所有这一切都是因为我们站在巨人的肩膀上,对吧?所以我们现在可以访问的当前模型越来越好。

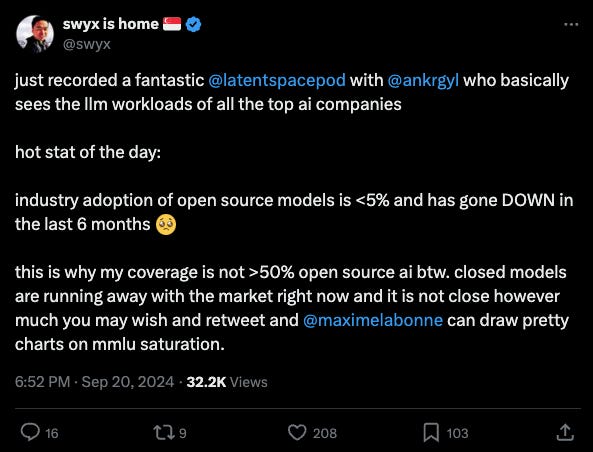

未来的趋势是开源模型与闭源模型之间的差距,它只会缩小到几乎没有区别的程度。然后我们就在同一个爱恋的领域。这就是为什么我认为我们在推理方面的早期投资以及我们在质量、延迟和成本平衡方面所做的所有工作都会得到回报,因为我们积累了很多经验,这使我们能够发布这个接近开放式质量的新模型。

我想,问题是,你认为缩小差距需要多长时间?因为我认为每个人都同意开源模型最终会赶上来。我认为有了 elementary 到 1 4 5 b,我们缩小了差距,然后没有一个重新打开了这么大的差距。而且还不清楚。显然。

你。

说你的模型。我们正在关闭这个。

事情是这样的,对吧?有公开的基准测试,它就是这样。但实际上,开源模型在某些维度上已经与闭源模型不相上下,甚至超过了闭源模型,对吧?例如,在编码领域,开源模型非常好。

在函数调用中,far 函数也很好,所以这完全取决于你是否构建了一个模型来解决所有问题,并且你想成为解决所有问题的最佳模型,或者在开源领域,它将专门化,对吧?所有这些不同的模型都专门从事某些狭窄的领域。而且合乎逻辑的是,它们在那个非常狭窄的领域可以做得非常好。我们的预测是,随着专业化的发展,将会有很多专家模型非常出色,甚至比通用的闭源模型更好。

我认为这是我仍然不确定的一场核心辩论,就复合 AI 与普通 AI 而言,因为你基本上是在对抗。

苦涩的教训。看看人类社会,我们很专业,你会对某人擅长做某事感到非常满意,对吧?这就是我们从古代进化至今的方式。

我们都是记者。我们做任何事情。现在我们高度专注于不同的领域。所以我预测,在 AI 模型领域,也会发生这种情况。除了苦涩的教训。

除了更好的教训,通过拥有专家和领域专家来获得短期收益,然后有人只需要在一个 10 倍大的模型上进行 10 倍多的推理、10 倍多的数据和 10 倍多的模型训练,也许无论当前的缩放比例如何,然后它就会超越所有单个模型,因为某些广义的智能/世界知识。

不,我认为这是 GPT 的核心见解。想要你。

那是对的。但是缩放定律,对吧?训练缩放定律,因为你有越来越多的数据要训练,你可以进行大量的计算,对吧?所以我认为在数据方面,我们正在接近极限,而唯一可以增加的数据是合成的生成数据。然后就在那里,对吧?因为如果你有一个非常好的大型模型,你可以生成非常好的合成数据,然后继续提高质量。这就是为什么我认为在 OpenAI 中,他们正在从训练缩放定律转向

推理缩放,这是测试时间等等。所以我绝对相信这是未来的方向,这就是我们擅长做推理的地方。

关于这一点,还有几个版本。你打算分享你的推理痕迹吗?

这是一个非常好的问题。我们仍在讨论中。是的,两者都这样做。

我会看到,例如,这很有趣,例如,ample 三个基准,如果你想被考虑进行排名,你必须发送推理痕迹,这实际上已经取消了一些我们之前的客人的资格。cosign 在 sweep entry 上做得很好,但他们不想泄露这些结果。这就是为什么你没有在 sweet we bench 上看到一个预览,因为他们没有他们的推理修复。我使用这些 IP。但同样,如果你要更开放,那么这是一种更开放的方式。所以你的模型不会是开源的,对吧?它将成为你提供的端点。这是一种进入,也似乎我有点像。

是的,这是我没有实际信息。一切进展得太快了。我们甚至还没有考虑过这个问题。我应该更准备好。

我的意思是,这是直播的。不,讨论它就像它一样很好,任何其他你想要反馈的事情,或者你正在思考的事情,讨论一些尚未决定的事情是很好的。关于这个新模型。我的意思是,这将是令人兴奋的。这将产生很多正确的嗡嗡声。

我很兴奋地想看看人们将如何使用这个模型。所以已经有关于它的 Reddit 讨论了。人们问了很多深刻的医学问题,而且似乎他们会正确地理解它,这令人惊讶。在内部,我们还要求模型生成什么是 AGI,它会生成一个非常复杂的标签思考过程。

所以我们玩得很开心,在内部测试这个。但我更好奇的是,人们将如何使用它?他们打算尝试和测试什么样的应用程序?这就是我们真正想听取社区反馈的地方,以及对我们的反馈,比如什么有效,什么无效,什么有效但令人惊讶,以及他们认为我们应该改进哪些方面,这些反馈将非常有帮助。

是的,我的意思是,所以我认为生产用户预览和迷你自发布以来,我会说他们非常,非常明显地跳跃质量,以至于他们让云在它上面,而且对于所有,他们让之前的最先进技术看起来像那样,这确实如此,这个区别。最重要的事情,实际上,你知道这个反馈或请求功能请求是人们想要控制预算。

因为现在,在所有一个 IT 中,它决定了自己的思考预算。但有时你知道问题有多难,你想实际告诉模型,花两分钟在这上面,或者花一些美元。也许是时间这些美元。

我不想要预算。有道理吗?我们实际上考虑过这个要求,它应该在某个时候需要支持。最初不是,但这很有道理。

有道理。所以这是一个关于你正在从事的事情的迷人概述,首先,我意识到,我不知道我是否曾经给你过这个反馈。但我认为你们是让我同意建议你们的原因之一,因为我认为当你们第一次见到我的时候,我有点怀疑。

我是。

为什么是这个,一起,像那些球员,非常,非常有竞争力的燃料,你为什么赢?而我真正改变主意的原因是我看到你们在发货,你知道的,我认为你们的表面积非常大。团队并没有那么大。

不,只有 40 个人。是的。

现在你正试图与开放的眼睛竞争。知道其他人一样,秘密是什么?

我认为是团队,团队是秘密。

哦,天哪。

所以没有。

不,不,我。我认为我们都来自非常一致的文化,因为大多数团队成员都来自物质和许多创业公司,所以我们真的相信结果。一个是结果,第二个是客户。

我们非常关注客户,我们不想为了采用而推动采用。我们真的想确保我们理解我们正在为客户提供很多商业价值,我们真的重视他们的反馈。所以我们会半夜醒来,为他们部署一些模型,为他们安排一些容量,是的,周末。

没有大脑,所以这就是我们作为一个团队的工作方式。团队的能力也非常高。所以,作为插件,我们正在招聘,我们正在非常快速地扩张。所以,如果我们对在流派领域从事最尖端的技术充满热情,那就来吧。

让我们稍微谈谈一下。客户旅程,我认为,更著名的客户压力。我们是第一个拥有 First 的口袋,显然,从那以后,他们就爆发了,因果关系没有关系。但你们尤其致力于一个快速的应用模型,你们是第一个在生产环境中使用光谱编码的人之一。也许只是谈谈与一起工作的幕后故事?

我说这里是一个非常,非常独特的团队。我认为独特之处在于团队拥有非常高的技术能力。对此毫无疑问,但他们已经决定,尽管许多公司都在构建编码副驾驶,他们会说,我会构建一个完整的堆栈,因为我可以。他们很独特,因为他们寻求伙伴关系。不是因为他们不能。他们完全有能力,但他们知道在哪里集中精力。对我来说,这是令人惊叹的。

当然,他们想找到一个快速伙伴。所以我们花了一些时间一起工作。他们非常积极地推动我们,因为为了提供高水平的产品体验,他们需要延迟。

他们需要互动,但也需要同时提供高质量。所以实际上,在我们支持课程的过程中,我们扩展了很多产品功能,而且他们发展得如此之快。我们必须在多个区域快速扩展。我们开发了一个非常高强度的推理堆栈,几乎类似于我们为物质所做的工作。

我认为这是一个非常,非常有趣的参与。因此,信任正在建立,他们意识到,嘿,这是一个他们可以真正与之合作的团队,他们可以与之一起发展壮大。这回到了,嘿,我们真的非常关注客户。所有与他们一起工作的工程师,都花了大量时间与他们一起同步讨论。我们并不重视会议,但我们就像那个总是开着的堆栈频道。是的,所以你几乎感觉像是一个团队。所以我认为这是。

真的非常突出,所以基本上就是一个VS Code,但大多数时候人们会使用封闭模型。我实际上也用过很多,所以你并没有参与其中,对吧?不像你拥有它或者与它有任何合作关系。我们没有参与其中,你参与的是Cursor的内部模型,他们的内部模型。

所以我不知道我能说什么,但是那些他们没有说的事情。

很明显,在4.0和SR中,下拉菜单是这样的,对吧?所以我假设Cursor是Fireworks一方,而另一方则在呼叫。然后,你看不看好这方面呢?你知道的,我认为你们在每秒1000个token方面取得了巨大成功。那是因为你们非常出色。还有更多可以提升的空间吗?

我们做了很多努力。实际上,当我提到Fire Optimizer时,对吧?所以,我认为我们有一个独特的自动化堆栈,一次一个,我们很早就将其部署到Cursor,基本上针对他们的特定工作负载进行了优化,这从中提取了很多价值。

并且在该部分取得了成功,实际上可以广泛采用。这就是为什么我们启动了一个名为Fire Optimizer的独立产品线。而推测性解码只是一种方法。这里的推测性解码不是静态的。我们实际上写了一篇博客文章来介绍它。

有很多不同的方法,你可以将小型模型与大型模型配对在一个模型系列中,或者你可以拥有平等的头脑等等。不同的方法有不同的权衡取舍。这实际上取决于你的工作负载。然后,对于你的工作负载,我们可以更好地调整平等的头脑、美杜莎的头脑或小型大型模型对,以获得最佳的延迟降低效果。所有这些都是Fire Optimizer产品的一部分。

我知道你提到了一些其他的推理提供商。我认为人们总是有的另一个问题是关于基准测试。所以你在不同的平台上会得到不同的性能。

人们应该如何思考,你知道的,比如,“嘿,Lama 3.2在MMLU上的表现是X”,但也许使用推测性解码,你会走一条不同的路径,也许一些提供商会运行一个量化模型。人们应该如何考虑他们应该在多大程度上关心你实际上是如何运行模型的?你在做的这些神奇的事情与原始模型之间有什么区别?

好的。所以有两个大的开发周期。一个是实验,他们需要快速迭代。他们不想考虑质量,他们只想尝试产品体验等等,对吧?这是一个。

然后看起来不错,他们想在产品市场适应后进行扩展,质量非常重要,延迟和其他所有事情都变得重要起来。在实验阶段,只需选择一个好的模型即可。不要考虑其他任何事情。确保你为你的产品生成了正确的解决方案,这就是重点。然后,在产品市场适应之后,就会出现一个三维优化曲线,涵盖质量、延迟和成本,你应该落在哪里。对我来说,这纯粹是一个产品决策。

对于许多产品来说,如果你选择较低的质量,但速度更快,成本更低,但这对产品体验没有影响,那么你应该这样做。这就是为什么我认为推理是验证的一部分。验证并不止于离线评估。验证将通过A/B测试和推理来进行。

这就是为什么我们可以提供各种不同的配置供你测试哪个是最佳设置。这是一个传统的产评估。所以产品评估也应该将你的新模型版本和不同的模型设置纳入考虑范围。

但是我想具体谈谈几个月前发生的一些主要竞争对手的事情。我的意思是,所有这些都是公开的。你对发生的事情有什么看法?也许你想纠正一下Fireworks是如何进行量化的,因为我认为很多人可能对你的量化方法有陈旧的看法,或者他们没有阅读澄清文章。

首先,我们总是很惊讶,在没有任何通知的情况下,我们被点名了。

具体来说,是点名,这通常不是……

是的,在公开帖子中。并且对我们的质量有一定的解读。所以我真的感到很惊讶。这不是一个很好的竞争方式,对吧?我们想公平竞争。而且,当一个供应商公布结果时,另一个供应商的解读总是极其偏颇的。

所以我们实际上避免做任何这些事情,我们很乐意与第三方合作,进行最公平的评估。所以我们非常惊讶,我们认为这不是一个了解竞争格局的好方法。所以我们做出了回应。

我认为,当谈到量化时,我们在解读方面实际上写了一篇非常详尽的博客文章。因为再一次,没有人说这是全部。我们有各种不同的量化方案。我们可以对模型的不同部分进行量化,从权重到激活,再到跨TPU通信。他们可以使用不同的量化方案,或者在整个过程中保持一致。再一次,这是一个权衡,这是一个在质量、延迟和成本这三个维度上的权衡。

对于我们的客户,我们实际上让他们找到最佳的优化点。我们有一个非常彻底的评估过程来选择这个点。但是对于自助服务,只有一个点可以选择。

没有自定义选项可用。所以当然,这取决于我们与许多客户的沟通。我们必须选择一个点。我认为最终结果,就像AA发表的一样,后来AA发表了一个质量指标。我们实际上看起来非常好。这就是我的意思,我会将质量或性能的评估留给第三方,并与他们合作,找到最公平的基准测试方法和方法。但我并不赞成点名批评其他竞争对手的做法。

数据库也是如此。我认为你是比较政治正确的那个,而Dima则比较……诸如此类。这是你在推特上的言论。

我们,是……

俄罗斯的,我们……

合作伙伴。不,实际上所有这些反应都是我们一起构建的,我们扮演不同的角色。

另一个我想谈论的,最后一个关于竞争方面的问题,人们认为托管开源模型存在价格战。我们讨论了市场的竞争力。你们的目标是在开源模型上实现盈利吗?

哦,绝对是的。但我认为这实际上……当我们考虑定价时,确实需要与我们提供的价值相协调。如果价值有限,或者很多人提供相同的价值,那么就没有差异化。只有一条路可走,那就是下降。

我看到了通过竞争,如果我退一步来看,定价来自……我们更多的是与封闭模型提供商、API进行比较,对吧?封闭模型提供商,他们的成本结构更加有趣,因为我们没有任何训练成本。我们专注于推理优化,这就是我们继续增加很多产品价值的地方。

这就是我们对产品的思考方式。但是对于封闭源API提供商和模型提供商来说,他们承担了大量的训练成本。他们需要将训练成本摊销到推理中。所以这就产生了一个非常有趣的动态,是的,如果我们匹配那里的价格,我认为他们将如何赚钱是非常非常有趣的。

对于听众来说,OpenAI 2024年40亿美元的收入,30亿美元用于计算训练,20亿美元用于计算推理,10亿美元用于研究计算摊销,7亿美元用于工资。所以这是……我的意思是,很多研发资金。

是的,所以我认为OpenAI基本上是想让它归零。这是一个我们正在运作的非常非常有趣的动态。但回到推理,对吧?正如我提到的,我们的产品是一个平台。我们不仅仅是一个单一模型的服务提供商,就像许多其他推理提供商一样,他们提供单一模型。我们有优化器可以高度定制你的推理工作负载。我们有一个复合AI系统,它可以显著简化你与高质量、低延迟、低成本的交互。所以这些都与其他提供商非常不同。

人们对你所做的工作不了解什么?我想人们会说,“好吧,Fireworks,你运行模型非常快。你有函数模型。Fireworks还有什么被低估的部分是更多的人应该尝试的吗?

是的,实际上,一个用户在x.com上发帖,他提到,“哦,实际上,Fireworks允许我以相同的成本上传LoRA适配器到服务模型,并以相同的成本使用它。”没有人提供过这个。这是因为我们有一个非常特殊的,就像我们去年推出了多LoRA一样。实际上,我们很长时间以来都有这个功能。很多人一直在使用它,但人们并不清楚的是,“哦,如果你找到了你的模型,你不需要使用按需服务。如果你发现你的模型是LoRA,你可以上传你的LoRA适配器,我们会将其部署为一个新模型。”

然后你使用,你得到你的端点,你可以直接使用它,但成本与基础模型相同。我很高兴用户为我们做营销。他发现了这个功能,但我们去年就有了。所以我认为反馈给我的是,我们有很多非常非常好的功能,正如Sean刚才提到的。我是这家公司的顾问,

我不知道你发布了推测性解码。

我们去年也推出了提示缓存。我们有很多,是的。所以我认为这是一个被低估的功能。如果他们是开发人员,你正在使用我们的自助服务平台,请尝试一下。

LoRA这件事很有趣,因为我认为你,人们向它添加额外成本的原因,并不是因为他们想向人们收费。通常在正常的LoRA服务设置中,需要为分配、加载这些权重以及将机器分配给该推理而付出成本。你为什么能避免呢?

是的,所以这是一种我们称之为多LoRA的技术。所以我们基本上让许多LoRA适配器共享相同的基模型,并且基本上大大减少了服务的内存占用。一个基模型可以支持数百到数千个LoRA适配器,然后基本上所有这些不同的LoRA适配器都可以共享相同的,比如将相同的流量导向相同的基模型,基模型占据主导地位。这就是我们这样宣传的方式。这就是我们如何管理令牌/美元,百万令牌定价与基模型相同的方式。

还有什么你想从社区请求的,或者你在模型方面或工具方面正在寻找的,你认为有人应该在这个方面努力吗?

是的。所以我们真的想从开始构建JNN或已经采用或开始考虑新的用例等的应用程序开发人员那里获得很多反馈,首先尝试使用Fireworks。让我们知道什么对你来说非常有效,你的愿望清单是什么,以及什么不好用,对吧?什么对你来说不起作用,我们想继续改进。对于我们的新产品发布,我们通常希望将其发布给一小部分人。我们通常首先在我们的Discord上发布,让一组人首先使用它。所以请加入我们的Discord频道。我们有很多沟通在那里进行。再次,你也可以给我们反馈。我们将开始办公时间,让你直接与我们的DevRel和工程师交谈,进行更长时间的交流。

你们正在全面招聘吗?

我们正在全面招聘。我们正在招聘前端工程师、基础设施云、基础设施工程师、后端系统优化工程师、应用研究人员,例如那些做过后训练、做过很多微调的研究人员等等。

好的。谢谢。感谢你们的收听。

谢谢你们的收听。

全面招聘,招聘前端工程师、基础设施云、基础设施工程师、后端系统优化工程师、应用研究人员,例如那些做过后训练、做过很多微调的研究人员等等。

好的。谢谢。感谢你们的收听。