We're sunsetting PodQuest on 2025-07-28. Thank you for your support!

Export Podcast Subscriptions

主

主持人

专注于电动车和能源领域的播客主持人和内容创作者。

我作为主持人,在本期节目中回顾了强化学习的历史和发展,从其早期在心理学和神经科学中的萌芽,到图灵奖得主安德鲁·巴托和理查德·萨顿的奠基性贡献,再到深度强化学习、逆强化学习以及基于人类反馈的强化学习(RLHF)等新兴技术。我详细阐述了强化学习的核心概念,包括试错学习、效果律、赫布法则、马尔科夫决策过程(MDP)等。我还介绍了强化学习在游戏领域的成功应用,例如AlphaGo和TD-Gammon。此外,我还探讨了萨顿关于Scaling Law和去中心化神经网络的最新观点,以及强化学习在AGI领域的未来潜力。总而言之,强化学习的发展历程展现了多学科融合的魅力,以及持续学习和探索的重要性。

Deep Dive

本期节目回顾了2024年图灵奖得主安德鲁·巴托和理查德·萨顿在强化学习方面的卓越成就,以及强化学习从AlphaGo到RLHF(基于人类反馈的强化学习)的广泛应用,并探讨了其未来潜力。

- 2024年图灵奖授予安德鲁·巴托和理查德·萨顿,表彰他们在强化学习方面的贡献

- 强化学习在AlphaGo和RLHF中都有重要应用

- 《苦涩的教训》一文对GPT大模型的诞生有重要影响

- 强化学习帮助大模型取得突破

Shownotes Transcript

【节目介绍】

本期节目聚焦强化学习,带你走进这一人工智能核心领域。从图灵奖得主巴托(Andrew Barto)和萨顿(Richard S. Sutton)的卓越成就,到强化学习从游戏到大模型的广泛应用,我们将回顾这段发展历程,探索RL的未来潜力。这是一场关于深度学习的历史和现状的回顾之旅,重新带你领略人工智能与各个学科的融合魅力。

【时间线】

01:40 从AlphaGo到RLHF(基于人类反馈的强化学习)

03:56 关于萨顿的《苦涩的教训》(The Bitter Lesson)

09:15 强化学习的启蒙奠基

- 爱德华·桑代克(Edward Thorndike),动物智能和效果法则(Law of Effect)

- 唐纳德·赫布(Donald Hebb),赫布法则(Hebb's Law)

- 沃伦·麦卡洛克(Warren McCulloch)和沃尔特·皮茨(Walter Pitts),神经元理论

- 安德烈·马尔可夫(Andrey Markov),马尔可夫决策过程(MDPs)

15:35 人工智能领域的早期发展

- 艾伦·图灵(Alan Turing),人工智能之父

- 贝尔蒙特·法利(Belmont Farley) & 韦斯利·克拉克**(**Wesley A. Clark),模拟第一个含有128个神经元的小型神经网络

- 克劳德·香农(Claude Shannon),Theseus迷宫老鼠

- 马文·明斯基(Marvin Lee Minsky),随机神经模拟强化计算器SNARC(Stochastic Neural Analog Reinforcement Calculator)

21:04 游戏让强化学习续命

- 亚瑟·塞缪尔(Arthur Samuel),IBM701上的第一个跳棋程序(Checkers)

- 理查德·乌尔曼(Richard Belleman),Dynamic programming equation(动态规划方程,即贝尔曼方程)

- 唐纳德·米奇(Donald Michie),井字游戏 Matchbox Educable Noughts And Crosses Engine (MENACE)

25:49 强化学习的诞生

- 安德鲁·巴托(Andrew Barto),2024年图灵奖得主,强化学习奠基人

- 约翰·霍兰德(John Henry Holland),遗传算法和学习分类器

- 诺伯特·维纳(Norbert Wiener),控制论奠基人

- 迈克尔·阿比布(Michael A. Arbib),神经计算

- 哈里·克劳普(Harry Clopf),享乐神经元

- 理查德·萨顿(Richard S. Sutton),2024年图灵奖得主,强化学习奠基人

- 杰拉尔德·特萨罗(Gerald Tesauro),TD-Gammon 西洋双陆棋游戏

- 沃尔夫拉姆·舒尔茨(Wolfram Schultz),多巴胺

40:35 强化学习的后继演化

- 大卫·西尔弗**(**David Silver),深度强化学习(Deep reinforcement learning)

- 吴恩达(Andrew Ng),逆强化学习(IRL,Inverse Reinforcement Learning)

- 皮特·阿贝尔 (Pieter Abbeel),机器人学习(Robot Learning)和模仿学习(Imitation Learning)

- 谢尔盖·列文(Sergey Levine),自主机器人和车辆

- 约翰·舒尔曼(John Schulman),深度强化学习(Deep RL)的策略优化(Policy Optimization)

45:30 萨顿最新的观点,《去中心化神经网络》(Decentralized Neural Networks)

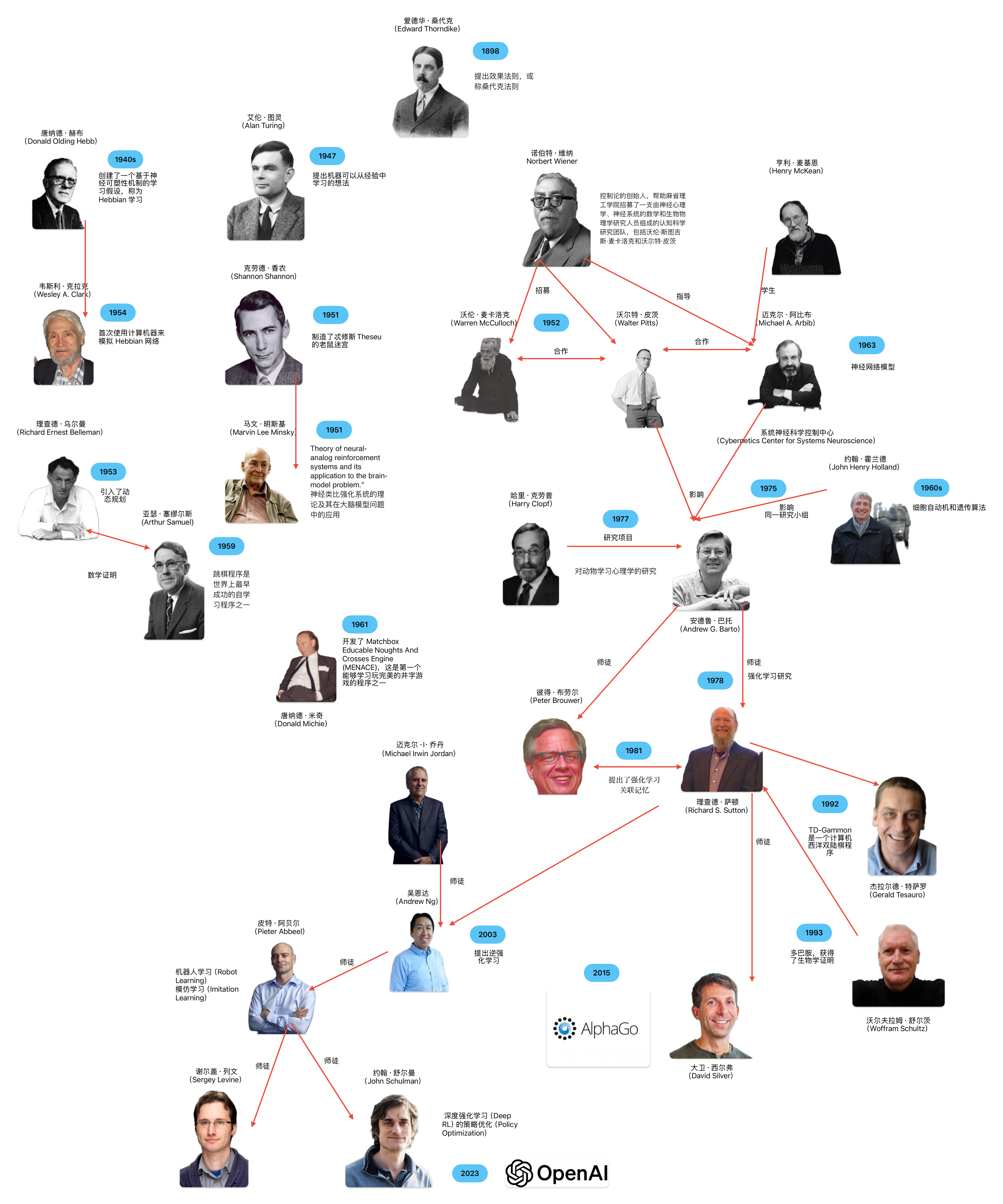

【关系图】

【延伸阅读】

【延伸阅读】

《苦涩的教训》(The Bitter Lesson)),理查德·萨顿(Richard S. Sutton) 2019

【片头和片尾音乐】

【感谢】

特别感谢[AIGC开放社区]和[AI重塑世界]的大力支持,请听友及时订阅微信公众号,查看本播客的文字版内容。欢迎订阅本播客节目,本节目在小宇宙、喜马拉雅、苹果播客、蜻蜓FM、网易云音乐、荔枝FM等平台均已上线。